この事例は掲載から時間が経過しているため内容が古い可能性があります。

用途や特徴・要件をふまえた、最新構成でのご提案をご希望の場合は、お気軽にお問い合わせください。

その他、用途や特徴、ハードウェア構成からもPC提案事例を検索いただけます。

- 事例No.PC-TW3J253601

-

参考価格:

参考価格:

6,256,800円保護中: 大規模マルチモーダルLLM学習向けワークステーション

用途:マルチモーダル大規模言語モデル (Idefics 2)を用いた、 動画・画像・音声・テキストを対象としたAI開発お客さまからのご相談内容

AIによる研究開発に向け、動画・画像・音声・テキストを対象としたマルチモーダル大規模言語モデル (Idefics 2) の学習環境を構築予定。

GPUにRTX Pro 6000 Blackwell 96GBを2枚搭載し、192GB VRAMを確保したい。

水冷CPUクーラー、512GBメモリ、複数のM.2 SSD、UbuntuとWindowsのデュアルブート環境を希望。

外部ストレージとの連携や将来的なGPU増設も視野に入れている。主な使用ソフトウェア・ライブラリは以下を予定している。

モデル・学習系 transformers, peft, bitsandbytes, accelerate, torchvision 音声・映像処理 whisper, ffmpeg, opencv-python インターフェース開発 Gradio, Streamlit, FastAPI データ・検索・RAG対応 datasets, langchain, FAISS, Chroma テガラからのご提案

GPUの選定と冷却対策

ご希望のBlackwell世代RTX Pro 6000 Workstation Edition (600W) については、複数枚搭載時に発熱リスクが高まるため、冷却効率を重視しMax-Q版 (300W) を採用しました。

Max-Qモデルは消費電力と発熱を抑えつつ、安定した処理性能を発揮するため、長時間の学習にも適しています。

将来的にはMax-Qモデルを最大4枚まで搭載可能な電源構成と筐体設計を採用しています 。CPU・メモリ構成について

Intel Xeon W7-3565X (32コア64スレッド) を搭載し、ECC REG DDR5 64GB×8枚で合計512GBメモリを構成。

メモリスロットには空きがあり、最大1TBまでの拡張も可能です。

水冷クーラー対応で、安定した高負荷処理が可能です。ストレージとOS環境

OS用に2TB SSD (Ubuntu 22.04 LTSとWindows 11 Proのデュアルブート) 、学習データ・モデル保存用に8TB SSDを搭載。

すべてM.2 NVMe Gen4で構成し、読み書き速度と信頼性を確保しています。

外部ストレージとの連携も想定し、NASのご提案も可能です。1対1の接続ですと、ネットワーク経由ではなくUSB接続という選択もございます。運用方法に合わせてご提案しますので、お気軽にご相談ください。拡張性と将来対応

2800W TITANIUM電源を採用し、GPUの追加やメモリ増設にも対応可能な設計です。

PCI-E x16スロットを6本 (初期状態での空スロットは4本) 備え、拡張性に優れています。

AI開発に必要な主要ライブラリ (transformers、whisper、langchainなど) にも対応しており、Visual Studio Code + Jupyter環境での開発が可能です。主な仕様

CPU Intel Xeon W7-3565X 2.50GHz (TB3.0時 最大4.8GHz) 32C/64T メモリ 合計512GB DDR5 5600 REG ECC 64GB x 8 ストレージ1 2TB SSD M.2 NVMe Gen4 x 2 ストレージ2 8TB SSD M.2 NVMe Gen4 x 2 ビデオ NVIDIA RTX PRO6000 Max-Q 96GB x 2基搭載 ネットワーク on board (1GbE x1 /10GbE x1) 筐体+電源 タワー型筐体 2800W TITANIUM OS Microsoft Windows 11 Professional 64bit その他 TPMモジュール

15A 200V電源用ケーブル C19 – C14

Ubuntu 22.04 デュアルブートキーワード

・Transformersとは

Transformersは、自然言語処理 (NLP) における事前学習済みトランスフォーマーモデル (BERT、GPT、T5など) を簡便に活用できるHugging Faceのライブラリ。テキスト分類、翻訳、要約、質問応答など多様なNLPタスクに対応し、研究開発から実運用まで幅広く利用されている。・PEFTとは

PEFT (Parameter-Efficient Fine-Tuning) は、大規模言語モデル (LLM) を効率的にファインチューニングするためのライブラリ。LoRAやPrefix Tuningなどの軽量手法を活用し、少数パラメータの更新で高精度なモデル適応を実現。計算資源の制約がある環境でも高性能なNLPモデルの構築が可能。・bitsandbytesとは

bitsandbytesは、量子化 (8bit/4bit) や低精度演算を通じて、大規模モデルのメモリ使用量と計算コストを大幅に削減するためのライブラリ。特にLLMの推論・学習において、GPUメモリの効率的活用を可能にし、低リソース環境でのモデル運用を支援。・Accelerateとは

Accelerateは、PyTorchベースの分散学習やマルチGPU/TPU環境でのトレーニングを簡素化するHugging Faceのライブラリ。複雑なデバイス管理や分散設定を抽象化し、コードの変更を最小限に抑えつつ高速な学習を実現。研究から実運用まで幅広く対応。・torchvisionとは

torchvisionは、PyTorch向けの画像処理ライブラリで、画像分類・物体検出・セグメンテーションなどのビジョンタスクに対応。事前学習済みモデル (ResNet、EfficientNetなど) やデータ拡張、画像変換ユーティリティを豊富に備え、ディープラーニングによる画像解析を効率化。・Whisperとは

Whisperは、OpenAIが開発した高精度な音声認識 (ASR) モデルで、複数言語に対応した自動文字起こし・翻訳機能を提供。研究用途から字幕生成、音声コマンド解析まで幅広く活用されており、ディープラーニングによる音声処理の標準ツールとして注目されている。・FFmpegとは

FFmpegは、動画・音声の変換、編集、ストリーミング処理に対応したオープンソースのマルチメディアフレームワーク。コマンドラインベースでの高速処理が可能で、音声抽出、フォーマット変換、トリミング、エンコードなど多彩な機能を備える。WhisperやOpenCVとの連携にも広く利用されている。・OpenCV-Pythonとは

OpenCV-Pythonは、画像処理・コンピュータビジョンのためのPythonバインディングを提供するOpenCVライブラリ。顔認識、物体検出、画像フィルタリング、動画解析などに対応し、AI・機械学習モデルとの統合も容易。研究開発から製品実装まで幅広く利用されている。・Gradioとは

Gradioは、機械学習モデルやAIアプリケーションをWebブラウザ上で簡単に公開・共有できるPythonライブラリ。インタラクティブなUIを数行のコードで構築可能で、画像分類、音声認識、自然言語処理などのデモ作成に最適。研究者や開発者がモデルの可視化・評価を迅速に行える環境を提供する。・Streamlitとは

Streamlitは、データサイエンスや機械学習プロジェクトを迅速にWebアプリ化できるPythonベースのフレームワーク。直感的なコード記述で、グラフ表示、データ入力、モデル結果の可視化などが可能。Jupyter Notebookの代替としても注目されており、社内ツールやプロトタイプ開発に広く利用されている。・FastAPIとは

FastAPIは、Pythonで高速かつ安全なWeb APIを構築できるモダンなフレームワーク。自動ドキュメント生成 (OpenAPI/Swagger) や型安全な入力検証を備え、AI・機械学習モデルのAPI化やマイクロサービス開発に最適。非同期処理にも対応し、高パフォーマンスなWebバックエンド構築が可能。参考:FastAPI – Modern, Fast (high-performance) web framework for building APIs with Python

・datasetsとは

datasetsは、Hugging Faceが提供する大規模な機械学習・自然言語処理 (NLP) 向けデータセット管理ライブラリ。ローカル・クラウド環境での高速なデータ読み込み、フィルタリング、前処理が可能で、トレーニング・評価・共有に最適。多言語コーパス、画像・音声データにも対応し、再現性の高いAI開発を支援する。・LangChainとは

LangChainは、大規模言語モデル (LLM) を活用したアプリケーション開発を支援するフレームワーク。外部データベース、検索エンジン、ツール群との連携を通じて、対話型AI、RAG (Retrieval-Augmented Generation) 、エージェント設計など高度なLLM活用を可能にする。PythonやJavaScriptでの実装に対応。・FAISSとは

FAISS (Facebook AI Similarity Search) は、高次元ベクトルの類似検索を高速に行うためのライブラリ。機械学習・自然言語処理・画像検索などにおいて、埋め込みベクトルのインデックス化と検索を効率化し、大規模データに対するリアルタイム検索を実現。GPU対応により、数百万件規模の高速検索が可能。参考:FAISS – Efficient similarity search and clustering of dense vectors

・Chromaとは

Chromaは、LLM向けのベクトルデータベースで、埋め込みベクトルの保存・検索・管理を簡単に行える。RAG構成やLangChainとの統合に最適化されており、ドキュメント検索、知識ベース構築、AIエージェントのメモリ管理などに活用される。Python APIを中心に、軽量かつ柔軟な設計が特徴。事例追加日:2025/08/15

ご注文の流れ

|

お問い合わせフォームよりご相談内容をお書き添えの上、 お問い合わせください。 (お電話でもご相談を承っております) |

|

弊社より24時間以内にメールにてご連絡します。 |

|

必要に応じてメールにて打ち合わせさせていただいた上で、 メール添付にてお見積書をお送りします。 |

|

お見積もり内容にご納得いただけましたら、メールにてご注文ください。 ご注文確定後、必要な部材を手配し PCを組み立てます。 (掛売りの場合、最初に新規取引票のご記入をお願いしております) |

|

動作チェックなどを行い、納期が確定いたしましたらご連絡いたします。 (納期は仕様や製造ラインの状況により異なります) |

|

お客様のお手元にお届けいたします (ヤマト運輸/西濃運輸) |

お支払い方法

お支払い方法は、お見積もりメール・お見積書でもご案内しています。

| 法人掛売りのお客様 |

| 原則として、月末締、翌月末日払いの後払いとなります。 |

| 学校、公共機関、独立行政法人のお客様 |

| 納入と同時に書類三点セット(見積書、納品書、請求書)をお送りしますのでご請求金額を弊社銀行口座へ期日までにお振込み願います。 先に書面での正式見積書(社印、代表者印付)が必要な場合はお知らせください。 |

| 企業のお客様 |

| 納品時に、代表者印つきの正式書類(納品書、請求書)を添付いたします。 ご検収後、請求金額を弊社銀行口座へお支払い期日までにお振込み願います。 |

| 銀行振込(先振込み)のお客様 |

| ご注文のご連絡をいただいた後、お振込みを確認した時点で注文の確定とさせていただきます。 |

修理のご依頼・サポートについて

弊社製PCの保証内容は、お見積もりメールでもご案内しています。

■お問合せ先

テガラの取り扱い製品に関する総合サポート受付のWEBサイトをご用意しております。

テガラ株式会社 サポートサイト

※お問い合わせの際には、「ご購入前」と「ご購入後」で受付フォームが分かれておりますので、ご注意ください。

| メール | support@tegara.com |

| 電話 | 053-543-6688 |

■テグシスのサポートについて

保証期間内の修理について

保証期間内におけるハードウェアの故障や不具合につきましては、無償で修理いたします。

ただし、お客様による破損や、ソフトウェアに起因するトラブルなど保証規定にて定める項目に該当する場合は保証対象外となります。

保証期間経過後も、PCをお預かりしての初期診断は無料で実施しております。

無料メール相談

PCの運用やトラブルにつきまして、メールでのご相談を承ります。経験・知識の豊富な技術コンサルタントが無料でアドバイスいたします。

※調査や検証が必要な場合はお答えできなかったり、有償対応となることがあります

オプション保証サービス

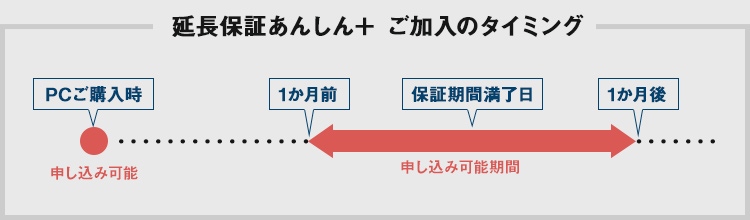

| 「あんしん+」 もしもの時の延長保証サービス |

|

PCのご購入時にトータル5年までの延長保証をご選択いただけます。また、ご購入後にも延長保証を申し込むことができます。

|

| HDD返却不要サービス |

|

保証期間内にPCのHDD(SSD)が故障した場合、通常、新品のHDDとの交換対応となり、故障したHDDはご返却いたしません。

|

| オンサイト保守サポート | |

|

故障発生時、必要に応じエンジニアスタッフが現地へ訪問し、保守対応を行うサービスです。

|

「お客様だけのオーダーメイドPC」を製作しています。

用途に応じた細かなアドバイスや迅速な対応がテガラの強みです。